Как вернуть страницы в индекс. Как быстро вернуть вывалившиеся страницы в индекс

Для начала немного предыстории. Был у меня небольшой сайт на 20-30 страниц, который я создавал в рамках . Развитием его особо не занимался, но тексты там были уникальные, дизайн вполне нормальный, а ссылки не продавались. Тем не менее оказался к нему беспощадным:) Оно, в принципе, логично, пользы от того сайта для посетителей было мало.

Собственно, после этого сайт был заброшен еще больше, и я даже не собирался продлевать домен, учитывая «новую идеологию», о том, что с некоторым сайтами . Но тут случается весьма забавная штука — судя по показателям RDS-bar страницы сайта благополучно вернулись в индекс.

Но куда еще более интересным для меня оказался показатель тИЦ, для которого было указано «АГС». Проверив некоторые другие сайты под фильтром, я наблюдал ту же картину — страницы вернулись в индекс с аннулированием тИЦа. Пояснение этого явления удалось найти в блоге Яндекса:

Новость на самом деле двоякая, есть в ней и плюсы, и минусы (все зависит от вашего способа онлайн заработка:)

Обновление 30.09.2018: Спустя некоторое время Яша подготовил для пользователей еще один сюрприз — запустил новый , этот показатель полностью заменил тИЦ.

Безусловным плюсом это нововведение будет для всех тех людей, которые не собирались зарабатывать на ссылках и попали под АГС случайно. Для них тИЦ не играл вообще никакой роли, тогда как выпадение сайта из индекса было практически началом конца веб-проекта (особенно, если большая часть трафика шла с Яндекса). Из-за фильтра могли пострадать как вебмастера, создающие узконишевые МФА с небольшим числом страниц, так и standalone блоггеры, пишущие нечастые заметки о своей жизни или размышлениях.

Минусы — . По сути, это еще один из факторов заката рынка ссылок. Конечно, глобального краха не случилось, но тенденция, как говорится, не утешительная. С одной стороны может показаться, что просто поменялось назначение АГС фильтра — мол вместо бана страниц, обнуляется тИЦ. Лично я думаю, что ситуация может быть куда более «глубокой». Фактически, у Яндекса появилась возможность избавляться от торговли ссылок без критических последствий для посетителей сайта.

Представьте себе ситуацию, когда толковый популярный ресурс попадает под за продажу ссылок. Это, разумеется, вызовет негодование у вебмастера, но и косвенно повлияет на посетителей, не дав им возможность найти хороший полезный сайт. А что если в выдаче после зафильтрованного сайта еще с 10-ток подобных, торгующих ссылками? Да, вместо них другие поднимутся в ТОПе выше, но пользы от этого у них не прибавится.

Теперь же Яндекс просто сможет аннулировать ТИЦ, что повредит только вебмастерам, а посетители проблем не ощутят. По сути, это даст фильтру АГС выполнять лучше те функции, для которых он и задумывался. А Яндекс, если захочет, в одночасье сможет зарубить весь рынок ссылок без проблем с выдачей.

Что же будет с ссылками дальше? Вопрос интересный. Вряд ли такой массивный и прибыльный рынок просто так уйдет в никуда. Да и сама сущность интернета в какой-то степени основна на гиперссылках с одних ресурсов на другие. Возможно, их роль станет ощутимо ниже (что сейчас и происходит), но полностью избавиться от ссылок? — мне кажется это нереальным.

Если говорить о биржах ссылок, то они могут вести какой-то собственный параметр для оценки доноров по аналогии с xtool. Можно учитывать PR, посещаемость, контент, возраст и много других параметров, определяя итоговую ценность того или иного сайта. Как бы там ни было одно становится явным — сейчас клепать сателлиты и разного рода ГС не выгодно и не перспективно. все больше перевешивает их «количественную выгоду».

А вы что думаете по поводу аннулирования ТИЦ?

Всем привет друзья. Сегодня у меня для вас две хорошие новости. Ну, скажем так – одна новость на 100% хорошая, а вот вторую хотел бы обсудить с вами в . Давайте начнем с той, которую хочу обсудить. Сегодня всеми нами любимая компания «Яндекс» опубликовала новость

о том, что все сайты, которые ранее попали под различные виды АГС, получают своего рода амнистию и будут возвращены в индекс. Но не сильно радуйтесь коллеги – страницы в , то вернутся, а вот ТИЦ так и останется обнуленным. При этом ссылки с таких сайтов не будут учитываться при продвижении, а сам сайт будет преднамеренно занижаться в результатах ранжирования.

Вот полный текст новости:

Исходя из этого, можно предположить, что таким поведением Яндекс проявляет лояльность к «Вебмастерам» и позволяет им развивать сайт в нужном правильном направлении. Мол, что вы хотите? Мы же ваши страницы в индекс вернули, остальное ваши проблемы. Развивайте сайт нужным образом, и когда он будет соответствовать нашим требованиям, мы вернем вам и позиции.

Все бы и ничего, но я думаю, что опять будет небольшая паника в рядах «Оптимизаторов». Ведь не секрет, что многие «Оптимизаторы» закупали ссылки с сайтов, где ТИЦ равнялся 0 и таким образом продвигали запросы, при этом экономя значительные суммы. Теперь же не поймешь, где сайт под АГС, а где нормальный, который не наращивал себе этот показатель, за ненадобностью. Да, конечно многие скажут, что можно проверять индексацию по РДС, смотреть на посещаемость ресурса, его обратные ссылки и т.д.

Но друзья, представьте себе ситуацию, когда вы закупаете по несколько сот или даже тысяч ссылок. Вы же не будете анализировать каждый 0-ой домен. И вот вывод напрашивается сам собой – не покупать ссылки с 0-ых сайтов. Опять «бедная» Сапа понесет финансовые потери, а многие «Вебмастера» просто уйдут с рынка.

Индустрия услуг (если ее так можно назвать) по выводу сайтов из-под АГС в принципе не должна пострадать. Пишется письмо «Платону», который сообщает, что сайт под санкциями, развивайте его и все будет нормально. И люди работают, так как раньше.

В общем веселая ситуация если посмотреть на это со стороны. Я как раз таки нахожусь в стадии активной работы по , а тут на тебе такая новость – сайты сами выйдут. Но ничего страшного в принципе не произошло, и эта новость все-таки хорошая при всех ее нюансах. Будем и теперь подстраиваться под новые алгоритмы Яндекса.

А что вы думаете друзья, по этому поводу? Отпишитесь, мне крайне интересно услышать ваши мнения.

Ну, а теперь давайте приступим ко второй новости, которая дарит мне хорошее настроение со вчерашнего утра. В целях на 2014 год, я запланировал массу дел, как по , так и по продвижению и развитию блога. Одним из этапов развития блога была полная смена дизайна моего детища. И вот наконец-таки я решился.

из 5)

из 5)

), я показал, как сделать сайт WordPress безопасным и перевести сайт на безопасный протокол HTTPS.

Примечание: 31 января вышел новый Chrom 5.6, и вы можете видеть, что все сайты без сертификатов безопасности стали метить красным цветом. Они обещали, они сделали.

Новый Chrom 5.6 это не все неприятности, появившиеся после двух первых статей. На третий день после перехода на https я увидел, что всех моих сайтов WordPress, ушел в ноль, проще говоря «рухнул». Я этого ждал, потому что понимал, что переход на HTTPS это сродни переезду сайта на новый домен (для поисковиков).

О трафике сайтов этого сказать не могу, потерь не было, даже по некоторым сайтам наблюдался плюс.

Если вами правильно и полностью сделана оптимизация сайта после SSL сертификации, ТИЦ вернется на прежнее место и трафик восстановиться.

Цитируя Платона (Яндекс): «Показатель тИЦ, будет актуализирован для Вашего сайта при ближайшем пересчёте, не переживайте». То есть в ближайший апдейт тИЦ, я должен увидеть прежние значения индекса цитирования. Посмотрим!

Замечу, что ТИЦ сайтов на самом деле восстановился через один апдейт ТИЦ.

Оптимизация сайта после SSL сертификации в двух подходах

В одной из прошлых статей по теме SSL я писал, что есть два подхода по оптимальному переходу на HTTPS, один официальный, другой из советов.

1. По первому, назовем его официальному способу, рекомендованному поисковиками, после активации SSL сертификата и доступности сайта по протоколу https и http, нужно сразу сделать полную переадресацию сайта http на https . При этом предварительно поменять ссылки сайта с абсолютных на относительные или безопасные. 2. По второму способу, чтобы не потерять трафик, переадресацию нужно делать через несколько месяцев, когда новый сайт https полностью войдет в индекс. Правда, не совсем понятно, что делать с дублями страниц и не приведет ли такое сохранение трафика к потере мест в выдаче.По своей практике скажу:

- После перехода на https по первому варианту, через сутки, тИЦ сайтов WordPress, обнулился. Кстати, тИЦ Joomla сайтов остался не тронутым.

- Посещаемость сайтов осталась прежней.

Пошаговая оптимизация сайта после SSL сертификации

Меняем ссылки сайта

Чтобы для браузеров сайт был действительно безопасным, вы должны все ссылки вашего сайта сделать относительными. Это касается и всех скриптов на сайте (счетчики, видео и т.п.).

Сделать это можно плагинами WordPress: HTTP/HTTPS Remover и Easy HTTPS (SSL) Redirection . Сторонние скрипты придется проверить и поправить руками. Возможно, от некоторых скриптов придется отказаться. можно использовать плагин: Really Simple SSL .

Все ошибки безопасности, включая Mixed Content вы можете посмотреть в инструментах браузера Chrome, на открытых страницах сайта. Достаточно воспользоваться правой кнопкой мыши и вкладкой «Посмотреть код» (для Chrome).

Ошибка Mixed Content есть

Переадресация сайта http на сайт https

Сделать переадресацию сайта http на сайт https . Для этого используйте один из трех вариантов:

- Возможности административной панели хостинга;

- Файлом [ .htaccess ], вписав в него директивы переадресаций.

Напомню, директивы файла [ .htaccess ] работают только для серверов на Apache. Если не так, пишите в суппорт вашего хостинга.

- Осторожно! Использовать панель сайта WordPress и вписать новый адрес с https в двух полях в настройках сайта «Общие».

Последний вариант переадресации может привести к потере доступа к административной панели сайта. Этот способ перенаправления используйте с осторожностью, только если сайт доступен по двум протоколам http и https и вы уже не сделали другие переадресации сайта http на https .

Сообщите поисковикам, что вы перешли на безопасный протокол

Необходимо внести сайт https в инструменты веб мастеров, как новый сайт.

Проведите все настройки в веб мастерах, для сайта https , а именно пройдите всю группу вкладок «Инструменты» для Яндекс.Вебмастер и «Сканирование» для Google.

Укажите сайт https как основной адрес сайта.

- Для Яндекс это вкладка «Переезд сайта».

- Для Google нужно просто добавить новый сайт с https .

Важно! Для Яндекс, в файле robots.txt смените директиву указав, домен с протоколом https вместо http . Там же смените протоколы адресов Sitemap.

Обязательно, проверьте открытие в браузере следующих страниц сайта по новому протоколу. Можно это сделать из панели веб мастера:

- Карты сайта Sitemap;

- Файла robots.txt ;

- Favicon сайта.

favicon сайта проверяется запросами:

- Для Яндекс: http://favicon.yandex.net/favicon/https://ваш_сайт.

- Для Google: http://www.google.com/s2/favicons?domain=https://ваш_сайт

Итоги

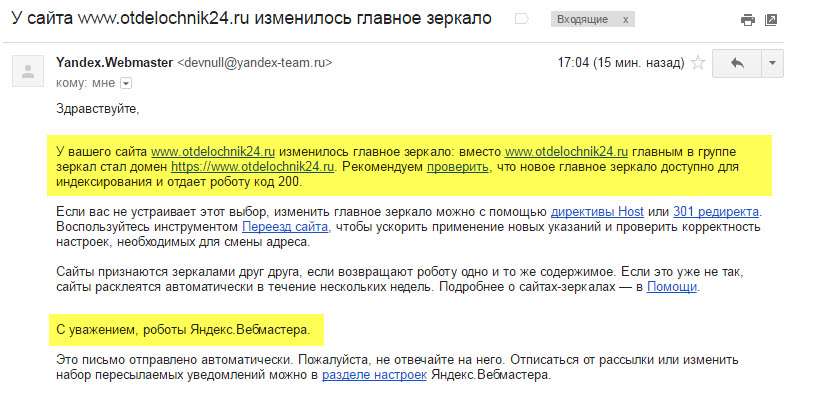

После выполнения указанных шагов, в инструментах веб мастеров вы будете видеть два сайта (1), один с http второй с https. В Яндекс. Вебмастер через некоторое время, система определит главное зеркало сайта (2) (о чем сообщит письмом) и покажет это подчиненным расположением сайта http.

С этого момента очень быстро, выдача сайта http начнет падать, а выдача сайта https начнет расти.

После обнуления выдачи сайта http (1) его можно удалить из веб инструментов Яндекс (2).

Сегодня – 120-й день с начала моих попыток заработать ссылками с двух блогов, созданных специально под продажу ссылок в ротапост.

Ну, поскольку тиц так и равен нулю,то заработка нет:) Зато я, кажется, понял пару вещей…

Как быстро вернуть вывалившиеся страницы в индекс.

Месяц назад в своем мини-отчете я зафиксировал, что на Блоге-1 было реально создано 25 страниц за отчетный месяц, и в то же время в яндексе число проиндексированных на сайте страниц уменьшилось на 67. Особенно грустно было видеть одновременно рядом: Яндекс – 96 страниц, Google – 381 страница.

Прошел месяц и – : Яндекс – 141 страница, Goodle – 399.

Что я сделал? Во-первых, закрыл в robots.txt все дубли, образованные wordpress-ом (categories, tags и дубли, созданные календарем). Это потому, что не очень разборчивый Яндекс кое-где выкинул из поиска оригинальные страницы, и оставил как раз /tags/ и т.п. Потом еще подумал и для пущей надежности физически поудалял все метки в записях (это легко сделать массово в dashboard).

Во-вторых, чтобы уменьшить кошмарную разницу, закрыл через webmaster гугла страницы, которые он держит в supplemental index, но которые считываются ротапостом и указываются в системе (запрос site:domen.ru). О, это долго! Гугл в этом плане недружелюбен к вебмастеру ни разу:(

В-третьих, проверил все старые страницы, которые должны быть в индексе, и посмотрел, что общего у выпавших. Откровенно говоря, фиговые страницы были – дурацкие рерайты, в основном не мной написанные (были такие на заре создания блога). Пару из них я даже и напрочь удалил, остальные подправил стилистически, отформатировал, добавил по 2-3 предложения и по картинке на страницу и – изменил дату создания на дату правки, то есть вынес пост на первую страницу блога.

И на будущее: в шаблоне главной страницы блога увеличил число ссылок на последние посты. До того были прямые ссылки лишь на 6 последних сообщений, я сделал 30. Таким образом, на главной странице всегда ссылки на посты последнего месяца, прямые. Это способствует более надежной индексации новых сообщений.

Вот и всё. Долго? Ну… Посидел несколько вечеров… Зато вижу сейчас результат.

Как без проблем держать кучу дублей /tags/ в индексе

Оба продажных блога я изначально делал без запрещения дублей в robots.txt Зачем? Ведь посты у меня не парсятся откуда-то (хотя уже жаль), а пишутся собственноручно, так что долго набирать серьезное, привлекательное для рекламодателей число страниц… Дубли в этом плане – хотя в некотором роде обман, но нужный. Не все же смотрят на качество текста, смотрят сначала на “одежку” – число страниц, тиц, цену…

И вот почему-то у Блога-1 страницы вывалились, а у Блога-2 все замечательно! Почему?

Сравнивая блоги, я смею предположить, что дело в двух факторах. Во-первых, шаблон второго блога изначально был очень сложным. Там множество превьюшек самых разных сообщений на всех страницах. С одной стороны, как бы куча неоригинальных вставок, мини-дублей, с другой – получается, что по сути неполные дубли выглядят очень по-разному. И они не вылетают из поиска.

А вот первый блог я как-то все время помещал в простые шаблоны: на главной анонсы нескольких последних постов, и очень похожие анонсы в разделах категорий… Скучные шаблоны…

В общем, себе я сделал вывод – шаблоны надо выбирать сложные:) После того, как увидел своими глазами результат, это кажется очевидным:)

Второй фактор: каждому посту лучше назначать один тег, максимум – два. И на странице в облаке тегов ограничивать их число, обязательно. Потому что уже даже не только на этих блогах, а и ранее на двух я пробовал, с лучшими намерениями, увеличивать и увеличивать число выводимых тегов. Это ВСЕГДА влечет к выпадению страниц из индекса. Не очень очевидно, но я настаиваю на этом следствии:)

О неудачном полуэкперименте и следующем шаге.

Попалось мне тут интересное рассуждение о том, что для подъема тиц достаточно получить ссылки с тех же источников, что имеет наиболее похожий на тебя сайт. Звучит логично.

Так что я нашел такой сайтик для Блога-1, скачал яззлом бэки и 15 декабря купил в sape.ru ссылки с тех же доноров. Бэков я увидел 213, ссылок купил только 57. Но, поскольку тиц у образца – 50, а бэки все как на подбор, тематичные, то я понадеялся, что эта небольшая прививка даст мне хотя бы червонец за месяц. Обломался:) Да, понятно, что эксперимент слабоват – копировать так копировать… Сейчас посмотрел внимательно, заметил в списке ссылок интересную особенность, надо будет попробовать повоторить, но это время займет…

Пока же еще такая мысль – всё-то я дешевыми ссылками пытаюсь в рай попасть… Закладки, sape, твиттеры, ЖЖ, блоги… Для разнообразия, создав одну интересную самому страничку на Блоге-2, решил купить на него ссылок в миралинкс. Три проставлено, три будет создано… Так что через месяц гляну сразу на два мини-результата…