Формула пропускной способности канала. Пропускная способность каналов связи

5.2. Пропускная способность канала связи.

Характеристики системы связи в значительной мере зависят от параметров канала вязи, который используется для передачи сообщений. Исследуя пропускную способность канала мы предполагали, что их параметры сохраняются постоянными. Однако большинство реальных каналов обладают переменными параметрами. Параметры канала, как правило изменяются во времени случайным образом. Случайные изменения коэффициента передачи канала m вызывают замирания сигнала, что эквивалентно воздействию мультипликативной помехи

Однородный симметричный канал связи полностью определяется алфавитом передаваемого сообщения, скоростью передачи элементов сообщения u и вероятностью ошибочного приема элемента сообщения р (вероятностью ошибки).

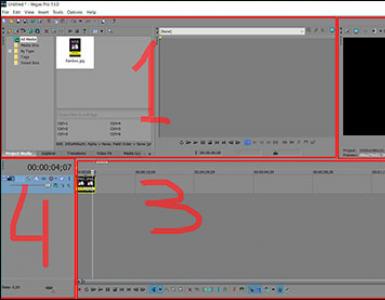

Пропускная способность канала будет вычисляться по формуле:

в частном случае для двоичного канала (m=2) получим формулу:

![]() , где р =0,003, t=15 10 -6

, где р =0,003, t=15 10 -6

Сравнивая пропускную способность канала связи и производительность источника (после оптимального кодирования) можем сделать вывод, что условие К.Шеннона выполняется, т.е. производительность источника меньше пропускной способности канала, что позволит нам передавать информацию по данному каналу связи. Для некодированного источника это условие выполняется также, т.к. производительность некодированного источника меньше производительности оптимально закодированного источника.

6. Помехоустойчивое кодирование.

При передаче цифровых данных по каналу с шумом всегда существует вероятность того, что принятые данные будут содержать некоторый уровень частоты появления ошибок. Получатель как правило устанавливает некоторый уровень частоты появления ошибок, при превышении которого принятые данные использовать нельзя. Если частота ошибок в принимаемых данных превышает допустимый уровень, то можно использовать кодирование с исправлением ошибок., которое позволяет уменьшить частоту ошибок до приемлемой.

Кодирование с обнаружением и исправлением ошибок как правило связано с понятием избыточности кода, что приводит в конечном итоге к снижению скорости передачи информационного потока по тракту связи. Избыточность заключается в том, что цифровые сообщения содержат дополнительные символы, обеспечивающие индивидуальность каждого кодового слова. Вторым свойством связанным с помехоустойчивым кодированием является усреднение шума. Этот эффект заключается в том, что избыточные символы зависят от нескольких информационных символов.

При увеличении длинны кодового блока (т.е. количества избыточных символов) доля ошибочных символов в блоке стремиться к средней частоте ошибок в канале. Обрабатывая символы блоками, а не одного за другим можно добиться снижения общей частоты ошибок и при фиксированной вероятности ошибки блока долю ошибок, которые нужно исправлять.

Все известные в настоящее время коды могут быть разделены на две большие группы: блочные и непрерывные. Блочные коды характеризуются тем, что последовательность передаваемых символов разделена на блоки. Операции кодирования и декодирования в каждом блоке производится отдельно. Непрерывные коды характеризуются тем, что первичная последовательность символов, несущих информацию, непрерывно преобразуется по определенному закону в другую последовательность, содержащую избыточное число символов. При этом процессы кодирования и декодирования не требует деления кодовых символов на блоки.

Разновидностями как блочных, так и непрерывных кодов являются разделимые (с возможностью выделения информационных и контрольных символов) и неразделимые коды. Наиболее многочисленным классом разделимых кодов составляют линейные коды. Их особенность состоит в том, что контрольные символы образуются как линейные комбинации информационных символов.

6.1. Принцип обнаружения и исправления ошибок.

Корректирующие коды строятся так, чтобы количество комбинаций М превышало число сообщений М 0 источника. Однако в этом случае используется лишь М 0 комбинаций источника из общего числа для передачи информации. Такие комбинации называются разрешенными, а остальные – запрещенными М-М 0 . Приемнику известны все разрешенные и запрещенные комбинации, поэтому, если при приеме некоторого разрешенного сообщения в результате ошибки это сообщение попадает в разряд запрещенных, то такая ошибка будет обнаружена, а при определенных условиях исправлена. Следует заметить, что при ошибке, приводящей к появлению другого разрешенного сигнала, такая ошибка не обнаружима.

Расстоянием Хемминга d между двумя последовательностями называется число позиций, в которых две последовательности отличаются друг от друга. Наименьшее значение d для всех пар кодовых последовательностей называется кодовым расстоянием.

Ошибка обнаруживается всегда, если её кратность, т.е. число искаженных символов в кодовой комбинации: g

Исправление ошибок в процессе декодирования сводится к определению переданной комбинации по известной принятой. Расстояние между переданной разрешенной комбинацией и принятой запрещенной комбинацией d 0 равно кратности ошибок g. Если ошибки в символах комбинации происходят независимо относительно друг друга, то вероятность искажения некоторых g символов в n-значной комбинации будет равна:

6.1. Коды с обнаружением ошибок.

Одним из кодов подобного типа является код с четным числом единиц. Каждая комбинация этого кода содержит помимо информационных символов – один контрольный, выбираемый равный 0 или 1 так, чтобы сумма количества единиц в комбинации всегда была четной.

Простейшим примером кода с проверкой на четность является код Бодо, в котором к пятизначным комбинациям информационных символов добавляется шестой контрольный символ: 11001,1; 10001,0. Правило вычисления контрольного символа находится как:

откуда вытекает, что для любой комбинации сумма всех символов по модулю два будет равна нулю. Это позволяет в декодирующем устройстве сравнительно просто производить обнаружение ошибок путем проверки на четность. Нарушение четности имеет место при появлении однократных, трехкратных и в общем случае нечетной кратности, что и дает возможность их обнаружить. Появление четных ошибок не изменяет четности суммы, поэтому такие ошибки не обнаруживаются.

Определим избыточность кода:

k=6 – число символов в помехоустойчивом коде

n=5 – число символов без избыточности

![]()

![]()

Заключение

В данной работе было рассмотрено:

1. Система когерентного приемника с ФМ. Рассчитав параметры и сравнив полученные в результате расчетов данные с другими системами приема сигналов выявлены некоторые преимущества и недостатки данной системы передачи и приема информационных сообщений. Также было проведено сравнение с идеальным приемником Котельникова, обеспечивающим потенциальную помехоустойчивость. Отмечено как можно улучшить характеристики приемника с помощью согласованных фильтров.

2. Передача непрерывных аналоговых сигналов цифровыми методами. Произведен анализ и сравнение дискретных методов (АИМ, ШИМ, ВИМ) с цифровым методом передачи непрерывных аналоговых сигналов ИКМ. Отмечены преимущества цифровых методов передачи информации по сравнению с аналоговыми.

3. Кодирование сообщений. Сравнивались и определялись характеристики статистического (эффективного кодирования) по сравнению с помехоустойчивым (избыточным) кодированием. Была определена пропускная способность канала связи и установлено, что данная система является работоспособной (т.е. выполняется условие К.Шеннона).

При рассмотрении передачи и приема сигналов методом ИКМ с кодированием сообщений, можно сделать вывод, что для повышения качества получаемых сообщений следует применять помехоустойчивое кодирование. Рассмотренный метод помехоустойчивого кодирования является самым простейшим. Для более эффективного использования канала связи нужно использовать более совершенные алгоритмы кодирования сообщений.

Литература

1. Зюко А.Г., Коробов Ю.Ф. Теория передачи сигналов – М.Связь 1972.

2. Б.Н.Бондарев, А.А.Макаров “Основы теории передачи сигналов” Новосибирск – 1969 г.

3. Э.Прагер, Б.Шимек, В.П.Дмитриев – “Цифровая техника в связи” – М. Радио и связь.

Лекция №2

Каналы передачи данных. Качество и эффективность ТВС.

Вопросы:

Типы и сравнительные характеристики линий и каналов связи.

Пропускная способность каналов связи.

Качество и эффективность ТВС.

Цели и задачи изучения темы : получение представления о типах и сравнительных характеристиках линий и каналов связи, задачах физической передачи данных по линиям связи, основных качественных показателях систем передачи информации, пропускной способности, достоверности и надежности работы ТВС.

Изучив тему, студент должен:

знать понятие классификации каналов связи, пропускной способности, достоверности и надежности работы ТВС

иметь представление о каналах и линиях связи и их физической природе, их преимуществах и недостатках, пропускной способности и скорости передачи информации по каналу, надежности работы и достоверности передачи данных

Изучая тему, необходимо акцентировать внимание на следующих понятиях: линия связи, канал связи, канал передачи данных, симплексные, дуплексные, полудуплексные, коммутируемые, некоммутируемые каналы, коаксиальный кабель, волоконно-оптический кабель, витая пара, канал радиосвязи, пропускная способность канала связи, надежность ТКС, достоверность передачи данных

2.1. Типы и сравнительные характеристики линий и каналов связи.

Среда передачи данных – совокупность линий передачи данных и блоков взаимодействия (т.е. сетевого оборудования, не входящего в абонентские системы).предназначенных для передачи данных между абонентскими станциями. Среды передачи данных могут быть общего пользования или выделенные для конкретного пользователя.

Линия и канал связи это не одно и то же.

Линия связи (ЛС) – это физическая среда, по которой передаются информационные сигналы.

Канал связи (КС) – средства односторонней передачи данных по линии связи.

Канал передачи данных – состоит из линий связи, по которым передается сигнал и аппаратуры передачи данных, преобразующие данные в сигналы, соответствующие типу линии связи.

Классификация каналов связи показана на рис. 2.1

|

Каналы связи |

|

Механические |

|

Физическая природа Акустические |

|

Оптические |

|

Электрические |

|

Форма передаваемой Аналоговые |

|

информации Цифровые |

|

Направление Симплексные |

|

передаваемой Полудуплексные |

|

информации Дуплексные |

|

Пропускная Низкоскоростные |

|

способность Среднескоростные |

|

Высокоскоростные |

|

Наличие Коммутируемые |

|

коммутации Выделенные |

Рис 2.1. Классификация каналов связи

По физической природе ЛС и КС на их основе делятся на:

механические – используются для передачи материальных носителей информации;

акустические – передают звуковой сигал;

оптические – передают световой сигнал;

электрические – передают электрический сигнал.

Электрические и оптические КС могут быть:

проводными , использующими для передачи сигналов проводниковые линии связи (электрические провода, кабели, световоды и т. д.);

беспроводными (радиоканалы, инфракрасные каналы и т.д.), использующими для передачи сигналов электромагнитные волны, распространяющиеся по эфиру.

По форме представления передаваемой информации КС делятся на:

аналоговые - по аналоговым каналам передается информация, представленная в непрерывной форме, то есть в виде непрерывного ряда значений какой либо физической величины;

цифровые – по цифровым каналам передается информация, в виде цифровых сигналов.

В зависимости от возможных направлений передачи информации различают:

симплексные КС - когда передатчик и приемник соединяются одной линией связи, по которой информация передается только в одном направлении (это характерно для телевизионных сетей связи);

полудуплексные КС- когда два узла связи соединены так же одной линией, по которой информация передается попеременно то в одном направлении то в противоположном;

дуплексные КС - когда два узла связи соединены двумя линиями, по которым информация одновременно передается в противоположных направлениях.

По пропускной способности каналы КС можно разделить на:

низкоскоростные – скорость передачи информации в которых от 50 до 200 бит/сек; это телеграфные КС, как коммутируемые так и некоммутируемые;

среднескоростные - – скорость передачи информации в которых от 300 до 9600 бит/сек; это аналоговые (телефонные) КС;

высокоскоростные (широкополосные) КС, обеспечивают скорость передачи информации выше 56000 бит\сек.

Каналы связи могут быть:

коммутируемые ;

некоммутируемые .

Коммутируемые каналы создаются из отдельных участков только на время передачи по ним информации; по окончании передачи такой канал ликвидируется.

Некоммутируемые (выделенные) каналы создаются на длительное время и имеют постоянные характеристики по длине, пропускной способности, помехозащищенности.

Физической средой передачи информации в низкоскоростных и среднескоростных КС обычно являются проводные линии связи.

Для организации широкополосных КС используются различные кабели, в частности:

неэкранированные витые пары;

экранированные витые пары;

коаксиальные;

волоконно-оптические.

Неэкранированная витая пара – это изолированные проводники, попарно свитые между собой для уменьшения перекрестных наводок между проводниками.

Экранированная витая пара – это изолированные проводники, попарно свитые между собой и помещенные в экранированную проводящую оплетку, которую положено заземлять.

Коаксиальный кабель представляет собой медный проводник, покрытый диэлектриком и окруженный защитной экранирующей оболочкой.

Основу волоконно-оптического кабеля составляют стеклянные или пластиковые волокна диаметром от 5 до 100 микрон окруженные твердым заполнителем и помещенные в защитную оболочку.

Ранее мы рассмотрели кодирование и передачу информации по каналу связи в идеальном случае, когда процесс передачи информации осуществляется без ошибок. В действительности этот процесс неизбежно сопровождается ошибками (искажениями). Канал передачи, в котором возможны искажения, называется каналом с помехами (или шумами). В частном случае ошибки возникают в процессе самого кодирования, и тогда кодирующее устройство может рассматриваться как канал с помехами.

Наличие помех приводит к потере информации. Чтобы в условиях наличия помех получить на приемнике требуемый объем информации, необходимо принимать специальные меры. Одной из таких мер является введение так называемой «избыточности» в передаваемые сообщения; при этом источник информации выдает заведомо больше символов, чем это было бы нужно при отсутствии помех. Одна из форм введения избыточности – простое повторение сообщения. Таким приемом пользуются, например, при плохой слышимости по телефону, повторяя каждое сообщение дважды. Другой общеизвестный способ повышения надежности передачи состоит в передаче слова «по буквам» – когда вместо каждой буквы передается хорошо знакомое слово (имя), начинающееся с этой буквы.

Пропускная способность канала, когда число элементарных символов более двух и когда искажения отдельных символов зависимы может быть определена с помощью второй теоремы Шеннона. Зная пропускную способность канала, можно определить верхний предел скорости передачи информации по каналу с помехами.

Рассмотрим на примере: Пусть имеется источник информации Х, энтропия которого в единицу времени равна , и канал с пропускной способностью Х. Тогда если

то при любом кодировании передача сообщений без задержек и искажений невозможна.

то всегда можно достаточно длинное сообщение закодировать так, чтобы оно было передано без задержек и искажений с вероятностью, сколь угодно близкой к единице.

Задача 2 : Выяснить, достаточна ли пропускная способность каналов для передачи информации, поставляемой источником, если имеются источник информации с энтропией в единицу времени =110 (дв. ед.) и количество каналов связи n = 2 , каждый из них может передавать в единицу времени К = 78 двоичных знаков (0 или 1); каждый двоичный знак заменяется противоположным с вероятностью μ=0.17 .

η(μ) = 0,434587

η(1 – μ) = 0,223118

η(μ) + η(1 – μ) = 0,434587 + 0,223118 = 0,657688

На один символ теряется информация 0,584239 (дв. ед.).

Пропускная способность канала равна:

С = 78∙(1 – 0,657688) =26,7≈27 двоичных единиц в единицу времени.

Максимальное количество информации, которое может быть передано по двум каналам в единицу времени:

27∙2 = 54 (дв. ед.), чего не достаточно для обеспечения передачи информации от источника, так как источник передает 110 дв. ед. в единицу времени. Для обеспечения передачи информации в достаточном объеме и без искажения необходимо увеличить количество пропускных каналов связи до трех. Тогда максимальное количество информации, которое может быть передано по трем каналам в единицу времени:

3*54=162 двоичных единиц в единицу времени. 162>110, следовательно информация будет передаваться без искажений.

Для передачи информации без задержек можно:

1. Использовать способ кодирования-декодирования;

2. Применять компандирование сигнала;

3. Увеличить мощность передатчика;

4. Применять дорогие линии связи с эффективным экранированием и малошумящей аппаратурой для снижения уровня помех;

5. Применять передатчики и промежуточную аппаратуру с низким уровнем шума;

6. Использовать для кодирования более двух состояний;

7. Применять дискретные системы связи с применением всех посылок для передачи информации.

©2015-2019 сайт

Все права принадлежать их авторам. Данный сайт не претендует на авторства, а предоставляет бесплатное использование.

Дата создания страницы: 2016-02-13

В любой системе связи через канал передается информация. Скорость передачи информации была определена в § 2.9. Эта скорость зависит не только от самого канала, но и от свойств подаваемого на его вход сигнала и поэтому не может характеризовать канал как средство передачи информации. Попытаемся найти способ оценки способности канала передавать информацию. Рассмотрим вначале дискретный канал, через который передаются в единицу времени символов из алфавита объемом При передаче каждого символа в среднем по каналу проходит следующее количество информации [см. (2.135) и (2.140)]:

где случайные символы на входе и выходе канала. Из четырех фигурирующих здесь энтропий -собственная информация передаваемого символа - определяется источником дискретного сигнала и не зависит от свойств канала. Остальные три энтропии в общем случае зависят как от источника сигнала, так и от канала.

Представим себе, что на вход канала можно подавать символы от разных источников, характеризуемых различными распределениями вероятностей (но, конечно, при тех же значениях . Для каждого такого источника количество информации, переданной по каналу, принимает свое значение. Максимальное количество переданной информации, взятое по всевозможным

источникам входного сигнала, характеризует сам канал и называется пропускной способностью канала. В расчете на один символ

где максимизация производится по всем многомерным распределениям вероятностей Можно также определить пропускную способность С канала в расчете на единицу времени (секунду):

Последнее равенство следует из аддитивности энтропии. В дальнейшем везде, где это особо не оговорено, будем под пропускной способностью понимать пропускную способность в расчете на секунду.

В качестве примера вычислим пропускную способность симметричного канала без памяти, для которого переходные вероятности заданы формулой (3.36). Согласно (3.52) и (3.53)

![]()

Величина в данном случае легко вычисляется, поскольку условная переходная вероятность принимает только два значения: , если еслн Первое из этих значений возникает с вероятностью а второе с вероятностью К тому же, поскольку рассматривается канал без памяти, результаты приема отдельных символов независимы друг от друга. Поэтому

Следовательно, не зависит от распределения вероятности В, а определяется только переходными вероятностями канала. Это свойство сохраняется для всех моделей канала с аддитивным шумом.

Подставив (3.56) в (3.55), получим

Поскольку в правой части только член зависит от распределения вероятностей то максимизировать необходимо его. Максимальное значение согласно (2.123) равно и реализуется оно тогда, когда все принятые символы равновероятны и независимы друг от друга. Легко убедиться, что это условие удовлетворяется, еслн входные символы равновероятны и независимы, поскольку

При этом и

Отсюда пропускная способность в расчете на секунду

Для двоичного симметричного канала пропускная способность в двоичных единицах в секунду

Зависимость от согласно (3.59) показана на рис. 3.9.

При пропускная способность двоичного канала поскольку при такой вероятности ошибки последовательность выходных двоичных символов можно получить, совсем не передавая сигналы по каналу, а выбирая их наугад (например, по результатам бросания монеты), т. е. при последовательности на выходе и входе канала независимы. Случай называют обрывом канала. То, что пропускная способность при в двоичном канале такая же, как при (канал без шумов), объясняется тем, что при достаточно все выходные символы инвертировать (т. е. заменить 0 на 1 и 1 на 0), чтобы правильно восстановить входной сигнал.

Рис. 3.9. Зависимость пропускной способности двоичного симметричного канала без памяти от вероятности ошибочного приема символа

Пропускная способность непрерывного канала вычисляется аналогично. Пусть, например, канал имеет ограниченную полосу пропускания шириной Тогда сигналы на входе и выходе канала по теореме Котельникова определяются своими отсчетами, взятыми через интервал и поэтому информация, проходящая по каналу за некоторое время равна сумме количеств информации, переданных за каждый такой отсчет. Пропускная способность канала на один такой отсчет

Здесь случайные величины - сечения процессов на входе и выходе канала и максимум берется по всем допустимым входным сигналам, т. е. по всем распределениям .

Пропускная способность С определяется как сумма значений Сотсч» взятая по всем отсчетам за секунду. При этом, разумеется, дифференциальные энтропии в (3.60) должны вычисляться с учетом вероятностных связей между отсчетами.

Вычислим, например, пропускную способность непрерывного канала без памяти с аддитивным белым гауссовским шумом, имеющим полосу пропускания шириной если средняя мощность сигнала (дисперсия не превышает заданной величины Мощность (дисперсию) шума в полосе обозначим Отсчеты входного и выходного сигналов, а также шума связаны равенством

н так как имеет нормальное распределение с нулевым математическим ожиданием, то и условная плотность вероятности при фиксированном и будет также нормальной - с математическим ожиданием и и дисперсией Найдем пропускную способность на один отсчет:

Согласно (2.152) дифференциальная энтропия нормального распределения не зависит от математического ожидания и равна Поэтому для нахождения нужно найти такую плотность распределения при которой максимизируется Из (3.61), учитывая, что независимые случайные величины, имеем

Таким образом, дисперсия фиксирована, так как заданы. Согласно (2.153), при фиксированной дисперсии максимальная дифференциальная энтропия обеспечивается нормальным распределением. Из (3.61) видно, что при нормальном одномерном распределении распределение будет также нормальным и, следовательно,

Переходя к пропускной способности С в расчете на секунду, заметим, что информация, переданная за несколько отсчетов, максимальна в том случае, когда отсчеты сигналов независимы. Этого можно достичь, если сигнал выбрать так, чтобы его спектральная плотность была равномерной в полосе Как было показано в отсчеты, разделенные интервалами, кратными взаимно некоррелированны, а для гауссовских величин некоррелированность означает независимость.

Поэтому пропускную способность С (за секунду) можно найти, сложив пропускные способности (3.63) для независимых отсчетов:

Она реализуется, если гауссовский процесс с равномерной спектральной плотностью в полосе частот (квазибелый шум).

Из формулы (3.64) видно, что если бы мощность сигнала не была ограничена, то пропускная способность была бы бесконечной. Пропускная способность равна нулю, если отношение сигнал/шум в канале равно нулю. С ростом этого отношения пропускная способность увеличивается неограниченно, однако медленно, вследствие логарифмической зависимости.

Соотношение (3.64) часто называют формулой Шеннона. Эта формула имеет важное значение в теории информации, так как определяет зависимость пропускной способности рассматриваемого непрерывного канала от таких его технических характеристик, как ширина полосы пропускания и отношение сигна/шум. Формула Шеннона указывает на возможность обмена полосы пропускания на мощность сигнала и наоборот. Однако поскольку С зависит от линейно, а от по логарифмическому закону, компенсировать возможное сокращение полосы пропускания увеличением мощности сигнала, как правило, нецелесообразно. Более эффективным является обратный обмен мощности сигнала на полосу пропускания.

В любой системе связи через канал передается информация. Ее скорость передачи была определена в § 4.2. Как видно из (4.25), эта скорость зависит не только от самого канала, но и от свойств подаваемого на его вход сигнала и поэтому не может характеризовать канал как средство передачи информации. Попытаемся найти способ оценки способности канала передавать информацию. Рассмотрим вначале дискретный канал, через который передаются в единицу времени v символов из алфавита объемом m. При передаче каждого символа в среднем по каналу проходит количество информации

I(A, В) = Н(А) - Н(А|В) = Н(В) - Н(В|А), (4.35)

где А и В - случайные символы на входе и выходе канала. Из четырех фигурирующих здесь энтропий H(A) - собственная информация передаваемого символа определяется источником дискретного сигнала * и не зависит от свойств канала. Остальные три энтропии в общем случае зависят как от источника сигнала, так и от канала.

* (Источником дискретного сигнала в системе связи (см. рис. 1.5) является совокупность источника сообщения и кодера. )

Представим себе, что на вход канала можно подавать символы от разных источников, характеризуемых различными распределениями вероятностей Р(А) (но, конечно, при тех же значениях m и v). Для каждого такого источника количество информации, переданной по каналу, принимает свое значение. Максимальное количество переданной информации, взятое по всевозможным источникам входного сигнала, характеризует сам канал и называется пропускной способностью канала в расчете на один символ

где максимизация * производится по всем многомерным распределениям вероятностей Р(A). Можно также определить пропускную способность С канала в расчете на единицу времени (например, секунду):

* (Если такого максимума не существует (что может быть при бесконечном числе возможных источников), то пропускная способность определяется как наименьшая верхняя грань sup I(А, В), т. е. такая величина, к которой I(А, B) может сколь угодно приблизиться, но не может ее превзойти. )

Равенство (4.37) следует из аддитивности энтропии. В дальнейшем везде, где это особо не оговорено, под пропускной способностью понимать будем пропускную способность в расчете на секунду.

В качестве примера вычислим пропускную способность симметричного канала без памяти, для которого переходные вероятности заданы (3.36). Согласно (4.36)

Величина

![]()

в данном случае легко вычисляется, поскольку условная (переходная) вероятность P(b j |a i) принимает только два значения: p/(m-1), если b j ≠a i и 1-р, если b j = a i . Первое из этих значений возникает с вероятностью р, а второе - с вероятностью 1-р. К тому же, поскольку рассматривается канал без памяти, результаты приема отдельных символов независимы друг от друга. Поэтому

Следовательно, Н(В|А) не зависит от распределения вероятности в ансамбле А, а определяется только переходными вероятностями канала. Это свойство сохраняется для всех моделей канала с аддитивным шумом.

Подставив (4.38) в (4.37), получим

Поскольку в правой части только член Н (В) зависит от распределения вероятностей Р(А), то максимизировать необходимо его. Максимальное значение Н (В) согласно (4.6) равно log m и реализуется оно тогда, когда все принятые символы b j равновероятны и независимы друг от друга. Легко убедиться, что это условие удовлетворяется, если входные символы равновероятны и независимы, поскольку в этом случае

При этом Н(В) = log m и

Отсюда пропускная способность в расчете на единицу времени

Для двоичного симметричного канала (m = 2) пропускная способность в двоичных единицах в единицу времени

С = v (4.42)

Зависимость C/v от р согласно (4.42) показана на рис. 4.3.

При р = 1/2 пропускная способность двоичного канала С = 0, поскольку при такой вероятности ошибки последовательность выходных двоичных символов можно получить совсем не передавая сигналы по каналу, а выбирая их наугад (например, по результатам бросания монеты), т. е. при р=1/2 последовательности на выходе и входе канала независимы. Случай С = 0 называют обрывом канала. То, что пропускная способность при р = 1 в двоичном канале такая же, как при р=0 (канал без шумов), объясняется тем, что при р = 1 достаточно все выходные символы инвертировать (т. е. заменить 0 на 1 и 1 на 0), чтобы правильно восстановить входной сигнал.

Пропускная способность непрерывного к а н а- л а вычисляется аналогично. Пусть, например, канал имеет ограниченную полосу пропускания шириной F. Тогда сигналы U(t) и Z{t) соответственно на входе и выходе канала по теореме Котельникова определяются своими отсчетами, взятыми через интервал 1/(2F), и поэтому информация, проходящая по каналу за некоторое время Т, равна сумме количества информации, переданной за каждый такой отсчет * . Пропускная способность канала на один такой отсчет

Здесь U и Z - случайные величины - сечения процессов U(t) и Z(t) на входе и выходе канала соответственно и максимум берется по всем допустимым входным сигналам, т. е. по всем распределениям U.

* (Можно вместо ряда Котельникова использовать разложение сигналов по- любому ортогональному базису и рассмотреть количество передаваемой информации на каждый член ряда. )

Пропускная способность С определяется как сумма значений Сотсч, взятая по всем отсчетам за секунду. При этом, разумеется, дифференциальные энтропии в (4.43) должны вычисляться с учетом вероятностных связей между отсчетами.

Вычислим, например, пропускную способность непрерывного канала без памяти с аддитивным белым гауссовским шумом, имеющим полосу пропускания шириной F, если средняя мощность сигнала (дисперсия U) не превышает заданной величины Р с. Мощность (дисперсию) шума в полосе F обозначим Р ш. Отсчеты входного и выходного сигналов, а также шума N связаны равенством

Z = U + N. (4.44)

Так как N имеет нормальное распределение с нулевым математическим ожиданием, то и условная плотность вероятности w(z|u) при фиксированном и будет также нормальной - с математическим ожиданием и и дисперсией Р ш.

Найдем пропускную способность на один отсчет (4.43):

Согласно (4.34) дифференциальная энтропия h(Z|U) нормального распределения w(Z|U) не зависит от математического ожидания и равна

![]()

Поэтому для нахождения С отсч следует найти такую плотность распределения w(U), при которой максимизируется h(Z). Из (4.44) учитывая, что U и N - независимые случайные величины, имеем для дисперсий:

D(Z) = D(U) + D(N) = P c + P ш. (4.45)

Таким образом, дисперсия Z фиксирована, так как Р с и Р ш заданы. Как было отмечено (см. стр. 114), при фиксированной дисперсии максимальная дифференциальная энтропия обеспечивается нормальным распределением. Из (4.44) видно, что при нормальном одномерном распределении U распределение Z будет также нормальным и, следовательно, обеспечивается максимум дифференциальной энтропии (4.34):

Переходя к пропускной способности С в расчете на секунду, заметим, что информация, переданная за несколько отсчетов, максимальна в том случае, когда отсчеты сигналов независимы. Этого можно достичь, если сигнал U(t) выбрать так, чтобы его спектральная плотность была равномерной в полосе F. Как было показано в § 2.2 [см. (2.48)], отсчеты, разделенные интервалами, кратными 1/(2F), взаимно некоррелированы, а для гауссовских величин некоррелированность означает независимость.

Поэтому пропускную способность С (за секунду) можно найти, сложив пропускные способности (4.46) для 2F независимых отсчетов:

С = 2FC отсч = F log (1 +Р с /Р ш). (4.47)

Она реализуется, если U(t) - гауссовский процесс с равномерной спектральной плотностью в полосе частот F (квазибелый шум).

Из (4.47) видно, что если бы мощность сигнала Р с не была ограничена, то пропускная способность была бы сколь угодно большой. Пропускная способность равна нулю, если отношение сигнал-шум Р с /Р ш в канале равно нулю. С ростом этого отношения пропускная способность увеличивается неограниченно, однако медленно, вследствие логарифмической зависимости.

Соотношение (4.47) часто называют формулой Шеннона. Эта формула имеет важное значение в теории информации, так как определяет зависимость пропускной способности рассматриваемого непрерывного канала от таких его технических характеристик, как ширина полосы пропускания и отношение сигнал-шум. Формула Шеннона указывает на возможность обмена полосы пропускания на мощность сигнала, и наоборот. Однако поскольку С зависит от F линейно, а от Р с /Р ш - по логарифмическому закону, компенсировать возможное сокращение полосы пропускания увеличением мощности сигнала, как правило, не выгодно. Более эффективным является обратный обмен мощности сигнала на полосу пропускания.

Заметим, что при Р c /P ш >>1 выражение (4.50) совпадает с характеристикой (1.2), названной в § 1.2 емкостью (объемом) канала.

Следует подчеркнуть, что формула Шеннона (4.47) справедлива только для канала с постоянными параметрами и аддитивным гауссовским белым (или квазибелым) шумом. Если распределение аддитивной помехи не является нормальным или же ее спектр неравномерен в полосе пропускания канала, то его пропускная способность больше, чем вычисленная по формуле (4.47). Мультипликативные помехи (замирания сигнала) обычно снижают пропускную способность канала.

На рис. 4.5 показаны зависимости С/F от среднего отношения Р с /Р ш для канала с постоянными параметрами (1) и канала с рэлеевскими замираниями (2). Из анализа кривых следует, что медленные рэлеевские замирания уменьшают пропускную способность канала не более чем на 17%.