Google Panda: Зверь совсем рядом. Панда от Google: что новенького

Здравствуйте, уважаемые читатели блога сайт! В продолжение темы настала очередь оценить действие Панды как одного из фильтров Google в отношении вебсайтов, пытающихся манипулировать результатами поисковой выдачи.

В прошлой статье были рассмотрены нюансы работы другого представителя гугловской фауны - , базовой задачей которого является понижение вебресурсов за ссылочный спам. Panda же пессимизирует вэбсайты в основном за внутреннюю переоптимизацию и низкое качество контента.

Зачем Гуглом был создан Панда и какие требования он предъявляет к вебпроектам

В общем и целом цели поисковых систем схожи: обеспечить максимальную степень релевантности страниц вебресурсов. Это необходимо для того, чтобы в результате ранжирования (в - о факторах, влияющих на содержание выдачи Яндекса и Гугла) вебресурсов в ТОПе оказывались бы те ресурсы, которые наиболее отвечали бы конкретным ПЗ ( - о видах поисковых запросов) пользователей.

Поэтому общие принципы механизмов, регулирующих качество находящихся в выдаче документов, у Гугла и Yandex тождественны. Алгоритм Panda, к примеру, наказывает практически за то же самое, что и , это касается и других фильтров обоих ПС, разница лишь в деталях.

Надо сказать, что за последнее время выдача и Google, и Yandex существенно очистилась. Особенно радует то, что резко сократилось число ГС, место которых заняли настоящие СДЛ (сайты для людей), хотя до идеала еще ой как далеко.

Однако, есть и другая сторона медали. Очень хорошо, что некачественные вебресурсы теряют надежду попасть в ТОП, что справедливо. Но во многих случаях вполне приличные ресурсы все равно оказываются не у дел. Это связано с тем, что поисковики постоянно экспериментируют, меняя содержание алгоритмов ради глобальной цели получения релевантной выдачи.

Сие благое намерение вполне понятно, впрочем оно сообразуется со стремлением Яндекса и Гугла добиться конечной цели в виде повышения своих доходов, которые достигают на данный момент десятков миллиардов долларов в год. Было бы весьма странно, если такие гигантские интернет корпорации не использовали бы такую возможность.

Расчет здесь весьма прост: чем больше пользователей будет находить конкретную информацию по искомому запросу, тем больший их процент будет доверять данному поиску. А в этом случае увеличится число кликов, совершаемых по объявлениям контекстной рекламы (в о монетизации сайта посредством контекста общая информация), доходы от которой составляют львиную долю ПС.

В общем, меркантильные интересы поисковиков налицо, что, впрочем, вполне логично. Кстати, частыми обновлениями алгоритмов они преследуют в том числе еще одну цель: создать условия для перехода части владельцев вебресурсов из SEO в другую область получения трафика для продвижения своего бренда, услуг либо товара, а именно с помощью использования контекста Директ или AdWords. То бишь, они стремятся увеличить армию рекламодателей, которые будут приносить дополнительный доход.

Но простые вебмастера, имеющие информационные проекты, не всегда имеют возможность таким образом заработать на сайте (в об этом подробнее) в соответствии с затраченными ресурсами (время, расходы на содержание вебпроекта и т.д.). Поэтому очень важно в данной ситуации вовремя предугадывать, в какую сторону поворачивает СЕО. Хотя в глобальном смысле алгоритмы не могут изменяться на 180 градусов, все-таки пожелания пользователей остаются теми же, однако нюансы могут быть. Дьявол, как известно, кроется в деталях.

Я позволил себе это информационное отступление, чтобы лишний раз напомнить о необходимости постоянного мониторинга всех событий, касающихся современного SEO, частью которого являются правила, устанавливаемые ПС, в том числе их сдерживающие фильтры.

Это необходимо, чтобы вовремя реагировать на них и обеспечить максимальную эффективность в продвижении своего проекта. Ну а теперь немедленно переходим к конкретике, актуальной именно на данный момент, и посмотрим, за что может наказать тот же Панда (этот алгоритм впервые появился в 2011 году). Итак, вэбсайт непременно понесет наказание, если Panda вдруг обнаружит следующее:

- большое количество некачественного контента: (копипаст), низкопробный рерайт и т.д.;

- переоптимизация, заключающаяся в переспаме ключевиков в подавляющем большинстве текстов, причем не только в теле статьи, но и в заголовках, тайтлах, описании. Кроме того, под лапу Панды могут угодить материалы, в которых неестественно часто использованы теги акцентирования (например, тот же STRONG, обеспечивающий подчеркивание жирным);

- объявления (в том числе ), не релевантные основному контенту на странице и в принципе огромное количество рекламных элементов;

- невообразимое число дублированного контента. Как известно, современные CMS (Content Management System) очень удобны для создания вэбсайта или блога и имеют массу преимуществ, но некоторые из них генерируют дубли;

- плохие поведенческие факторы (время, проведенное посетителями на вебсайте, показатель отказов, глубина просмотра);

- массу не работающих линков, ведущих на страницу с ошибкой 404 ( о том, как создать корректную page not found, можете узнать все детали);

Как определить, под действием какого алгоритма находится вебсайт

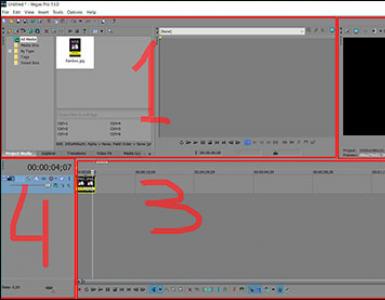

Итак, если вы увидите, что число посетителей, приходящих с поиска Гугл, вдруг начинает неуклонно падать (и это не связано с присущими вашему вэбсайту обычными сезонными колебаниями), то весьма вероятно, что ресурс попал под один из фильтров. Отслеживать посещаемость с поисковых систем удобнее всего используя LiveInternet, который обладает богатым функционалом. Вот график изменения посещаемости одного из моих проектов:

Как видите, с сентября 2014 года кривая трафика начала неуклонно ползти вниз. Как раз в это время был последний апдейт Панды. Проследить обновления всех фильтров можно с помощью специализированных сервисов, одним из которых является Moz.com , где представлены все даты обновлений:

Так что в данном случае все ясно, именно фильтр Panda стал причиной падения посещаемости. Однако не всегда так легко соотнести даты обновления алгоритмов и начавшиеся проблемы с проседанием позиций вэбресурса и, соответственно, трафика. Поэтому существует зарубежный ресурс Barracuda, который предлагает специальный инструмент Panguin Tool :

С его помощью можно проследить, например, кто из сладкой парочки Гугла (Панда или Пингвин) стал причиной крушения вашего вэбсайта. Правда, для этого необходимо предоставить доступ к вашей статистике Google Analytics. Конечно, мировому гиганту поиска можно доверять в вопросе сохранения конфиденциальных данных, но чем черт не шутит. Ведь с основным аккаунтом Google (в о создании аккаунта в Гугле все подробности) обычно связана и учетная запись , что как-то напрягает.

В этой связи я вспомнил, что вполне возможно делегировать права на данные Аналитикс другому своему профилю, на котором нет никакой важной информации, благо Google не накладывает ограничения на количество учетных записей. Что и было сделано. Для этого я вошел во вкладку «Администратор» основного профиля Гугл Analytics и выбрал раздел «Управление пользователями»:

Там прописал адрес электронной почты, соответствующей другой моей учетной записи. Этим самым я предоставил право получения статистических данных через другой аккаунт:

Естественно, отреагировал на это положительно, кликнув по соответствующей кнопке. Дальше вылезло сообщение, предлагающее выбрать конкретный канал статистики:

В итоге была сформирован результирующий график, где точные даты обновлений алгоритмов накладываются на кривую изменения посещаемости моего блога.

Если проанализировать эту графическую информацию, то не заметен спад посещаемости после какого-либо апдейта. Единственный непродолжительный участок провала, где трафик упал до нуля, связан со снятием счетчика Аналитикс, сейчас уже не помню, по какой причине. Следовательно, сайт, похоже, пока избежал острых клюва и когтей Панды либо Пингвина.

Если по графику невозможно понять, под какой фильтр угодил вэбсайт (безусловно, бывает и такое), то при анализе трафика надо обратить внимание на следующее. Если вас клюнул Penguin, то проседание позиций, скорее всего, будет только для тех запросов, по которым вы продвигаете заспамленные "плохими ссылками" страницы. Если же покусал Panda, то падение начнется по всем ключевикам, следовательно, будет более стремительным.

Как обойти Google Panda или выйти из-под этого фильтра

В первой главе текущей публикации мной были упомянуты нарушения, при обнаружении которых Пандой может быть наказан вебресурс. Теперь рассмотрим, как сделать так, чтобы избежать его лап. Или, если вам не удалось этого избежать, каким образом восстановить позиции своего ресурса. Итак:

2. Ликвидировать переизбыток ключевых слов в Тайтле, заголовках H1-H3, Description (описании). Все заглавия и описания статей должны быть читабельны, понятны пользователям и цепляющими взгляд. Кроме этого, они обязаны полностью соответствовать содержанию публикаций. Ведь в противном случае читатели покинут вебсайт, поскольку не найдут обещанного.

3. Убрать лишнюю рекламу со страниц вепроекта, особенно те блоки, которые не являются релевантными его содержанию. Ведь такие рекламные объявления не принесут достойного дохода, а навредить могут серьезно. Также откажитесь от использования большого количества агрессивной рекламы типа попандеров, кликандеров, всплывающих окон и им подобных элементов.

4. Уничтожить весь имеющийся дублированный контент. Как это сделать, например, для блога WordPress с древовидными комментариями, я подробно писал в статье о страниц, которые, поверьте, могут стать причиной полного краха. Это действительно серьезно.

5. Улучшить поведенческие факторы вебсайта, качество которых связано с предыдущими шагами. Если реализуете первые три пункта, то большая часть работы будет выполнена.

Это основные пункты, следование которым поможет избежать Панды или, в худшем случае, освободиться от его объятий. Помните, что Panda это машинный алгоритм, который накладывается автоматически. Никакие обращения в хелп Гугла не помогут ускорить его снятие. Только после всех исправлений вы можете обратиться с подробным описанием всех предпринятых вами действий.

Поэтому лучше, конечно, изначально не давать ему повод испытать свои зубы на вас. Ну а если не посчастливиться, что вполне возможно при современном развитии событий, не примените воспользоваться моими рекомендациями, данными чуть выше. Хуже точно не будет.

Давным давно, в далёкой-далёкой галактике, поисковая система Google создала алгоритм, который получил название Panda. Разработали этот алгоритм всего два человека, это Амит Сингал вместе Мэтт Катс. Этот алгоритм отличается от своих собратьев тем, что, прежде всего он рассчитан на человеческий фактор. А также алгоритм учитывает и другие факторы при ранжировании сайта.

В этом материала мы постарались собрать всё, что может касаться алгоритма Google Panda, как его определить и как под него не попасть, чтобы с успехом .

Количество и качество ссылок (ссылочный профиль)

Алгоритм также учитывает ссылки. Причём он учитывает все ссылки, и входящие и исходящие. Требование всего одно, и тот и другой сайт должен быть одной тематики. Конечно же, алгоритм отслеживает количество входящих и исходящих ссылок, но это не самый важный фактор при ранжировании сайта. Первое, что его интересует, это человеческий фактор. Другими словами, он внимательно смотрит за пользователем на сайте. Что он делает, сколько времени проводит, читает ли он материал, заполняет ли формы и так далее. Конечно, разработчики проделали огромную работу, по созданию и обкатке этого алгоритма. По сути, этот алгоритм потребовал шлифовки и других алгоритмов, чтобы поисковая система могла выдавать только качественные сайты.

При введении этого алгоритма при ранжировании сайта, попасть в ТОП поисковой выдачи могут только реально полезные и качественные сайты. Именно этот алгоритм, и сделал поисковую систему Google мощным поисковым инструментом. Это подтверждается тем, что аудитория Гугл растёт в геометрической прогрессии. Более того, бюджет компании так же растёт как на дрожжах. Ведь обмануть пользователя ещё можно, используя так называемые чёрные методы продвижения. Различные фишки и агрессивную рекламу. А вот инвестора обмануть нельзя, и он прекрасно знает и осознаёт, что Гугл – дело прибыльное.

Конечно, такой рост компании это заслуга не только одного алгоритма. А теперь вернёмся к теме статьи.

Поведенческие факторы

В этот показатель входит целый ряд критериев, такие как:

- показатель отказов;

- сколько времени проводит человек на сайте за одну сессию;

- сколько страниц он посетил за один визит;

- возвращается ли он на сайт и как часто;

- сколько показывается сайт в выдаче, и сколько переходят по ссылке (CTR).

Все это алгоритм отслеживает, причём он делает это для каждого пользователя. То есть он следит за каждым посетителем и внимательно смотрит, что он делает, переходит ли по ссылкам, заполняет ли формы, прокручивает страницу вниз или нет и так далее. Таким образом, алгоритм определяет, отвечает ли на запросы пользователь сайт или отдельная страница и находит ли пользователь ответ на запрос введённый в поисковую строку.

Как понять, что сайт попал под фильтр Panda и что делать?

- Резкое падение трафика.

Если Вы обнаружили, что количество переходов из Google резко снизилось, то одной из возможных причин, может являться Panda и технические проблемы сайта, которые не были выявлены:

— медленный ответ сервера;

— недоступность страниц и прочие.

Чтобы проверить это внимательно проанализируйте данный и . - Аккуратнее с ссылками. Хоть ссылки для Google остаются ключевым факторам ранжирования, не стоит слишком заострять внимание на них, потому что поисковик давно научился отличать естественные ссылки от закупленных, а так же выявлять неествественный прирост ссылочной массы.

- Плохие тексты.

Тексты написанные не человеческим языком, с множеством орфографических ошибок, короткие, не уникальные и размещённые в виде газетной полосы — убьют любой сайт, так как служат сигналом для Панды понизить сайт в выдаче.

Что делать? Пишите качественный, уникальный контент, который полезен для пользователей, тщательно его проверяйте и редактируйте. - Нет видео и фото.

Если Вы не разбавляйте содержание статей и страниц сайта, картинками, инфографикой и видео, то глазу читателя просто не за что зацепиться и если это плохо для пользователя, значит это не нравится Панде.

Добавляйте больше оптимизированных фото и видео, заполняя атрибуты alt и title . - Мало внутренних ссылок. Зайдя на сайт, пользователь должен легко и не принуждёно перемещаться по нему, при этом попадая именно на те страницы, которые он ожидал увидеть. И здесь очень важно сделать грамотную внутреннюю перелинковку, которая позволит переходить на такие страницы. Так же отличным решением будет разместить виджеты с последними записями в блоге, самыми популярными статьями и наиболее интересными разделами.

И помните: «Лучше не злите Панду!».

4 февраля 2012 года прошел ровно год с того времени, как мир услышал о Звере, которого все знают под именем Panda. После его многочисленных и жестоких нападения много чего изменилось в понятии о хорошем сайте, продвижении в общем. Возможно, еще больше изменится в будущем. Но пока можно и нужно подвести итоги произошедших перемен, чтобы не стать следующей жертвой Зверя.

Что такое Google Panda

Panda – это фильтр Гугла, который позволяет отделять полезный контент от контента без какой-либо значимой пользы.

Panda называется “обновлением”, потому что он проходит периодически. При этом Гугл каждый раз “просеивает” контент: страдают те сайты, которые так ничему и не научились, “поправленным” же сайтам удается избежать фильтра.

На данный момент Panda – один из более 200 сигналов, которые Google принимает во внимание при ранжировании сайтов.

Хронология Panda

- Panda 1.0: 24 февраля, 2011

- Panda 2.0: 11 апреля, 2011

- Panda 2.1: 10 маяб 2011

- Panda 2.2: 16 июня, 2011

- Panda 2.3: 23 июля, 2011

- Panda 2.4: 12 августа, 2011

- Panda 2.5: 28 сентября, 2011

- Panda 3.0: 19 октября, 2011

- Panda 3.1: 18 ноября, 2011

- Panda 3.2: 18 января, 2012

Как это было

Panda 1.0 – В США из клетки сбежал страшный зверь

В феврале 2011 года в США объявлено чрезвычайное положение: из клетки сбежал Зверь, который заставил трепетать владельцев низкокачественных сайтов с кучей дублированного контента. Позиции таких сайтов уже никак нельзя было спасти, и их владельцам с ужасом пришлось смотреть, как они неумолимо падают. В итоге в США Зверь затронул 12% поисковых запросов.

Panda 2.0 – Зверь идет дальше

Америка стала слишком тесной для Panda, и он пошел дальше по англоязычным странам. На этот раз его жертвами стали Великобритания и Австралия. Он также добрался до всех запросов на английском языке за пределами англоязычных стран. Ужас охватил вебмастеров с еще большей силой.

Panda 2.1-2.4 – Зверь ушел в затишье

Набеги Panda становились менее болезненными, зато более частыми. Многие вебмастера расслабились и решили, что все обошлось. Лишь некоторые в тайне догадывались, что худшее впереди.

Panda 2.4 – Весь мир в опасности

Волна гнева Зверя прокатилась по земному шару, минуя лишь поисковые запросы на китайском, японском и корейском. Несмотря на свою жестокость, Зверь затронул только 6-9% поисковых запросов. Многие посчитали это чудом.

Panda 2.5 – Зверь повсюду

Раньше те сайты, которые Panda обошел стороной, считали, что им ничего уже не грозит. Но теперь все изменилось: даже, если Зверь прошел мимо сегодня, завтра он мог вернуться – и тогда ничто не могло спасти его жертв.

Panda 3.0 – Зверь нападает незаметно

Со временем Panda становился все умнее, а его методы все изощреннее. Он затаился, чтобы никто не смог догадаться, когда произойдут его новые нападения. То, что они будут – знали все, загадкой оставалось только время.

Зверь обхитрил всех и напал тогда, когда его ждали меньше всего. В свои жертвы он выбирал не только новые сайты, но и те, которые не выучили урок с первого раза и не сделали работу над ошибками.

Panda 3.1 – Зверь ушел в отпуск

Panda решил отдохнуть. Во время его отдыха поступали сообщения о его нападениях, но они были редки и не так жестоки, как обычно. В итоге – затронуто менее 1% поисковых запросов.

Panda 3.2 – второй круг Зверя

Методы Panda остались все теми же, но он начинает сначала. Все тряситесь от страха: и те, на кого Зверь уже нападал и тем более те, кто не подвергся его нападениям.

Спасение возможно

Если твой сайт усеян дубликатами, не важно, внутренними или внешними; даже если тебе кажется, что ты тщательно их спрятал в каком-нибудь закоулке сайта – знай: Зверь может стоять за дверью и ждать, пока ты потеряешь бдительность . Дубликаты и некачественный контент привлекают его, как кровь акулу, поэтому избавляйся от них, если хочешь, чтобы твой сайт жил.

И еще немного о Panda, только в картинках и на английском.

Несмотря на то, что изменения в алгоритмах Google – одна из самых животрепещущих тем в сфере SEO , многие маркетологи не могут с уверенностью сказать, как именно алгоритмы Панда, Пингвин и Колибри повлияли на ранжирование их сайтов.

Специалисты компании Moz подытожили наиболее значимые изменения алгоритмов Google и буквально разложили по полочкам информацию о том, за что отвечает каждое обновление.

Google Панда – Инспектор по качеству

Алгоритм Панда, главной целью которого является повышение качества результатов поиска , был запущен 23 февраля 2011 года. С его появлением тысячи сайтов потеряли свои позиции, что взбудоражило весь Интернет. Поначалу оптимизаторы думали, что Панда штрафует сайты, замеченные в участии в ссылочных схемах. Но, как позже стало известно, борьба с неестественными ссылками не входит в круг полномочий этого алгоритма. Все, чем он занимается, – это оценка качества сайта.

Чтобы узнать, не угрожает ли вам опасность попасть под фильтр Панды, ответьте на такие вопросы:

- Стали бы вы доверять информации, размещенной на вашем сайте?

- Есть ли на сайте страницы с дублированным или очень схожим контентом?

- Вы бы доверили данные вашей кредитной карточки подобному сайту?

- Содержатся ли в статьях орфографические или стилистические ошибки, опечатки?

- Статьи для сайта пишутся с учетом интересов читателей или же только с целью попасть в результаты поиска по определенным запросам?

- Есть ли на сайте оригинальный контент (исследования, отчеты, аналитика)?

- Выделяется ли ваш сайт среди конкурентов, которые выдаются вместе с ним на странице результатов поиска?

- Пользуется ли ваш сайт авторитетом в своей сфере?

- Уделяете ли вы должное внимание редактированию статей?

- Предоставляют ли статьи на сайте полные и информативные ответы на вопросы пользователей?

- Вы бы стали добавлять сайт/страницу в закладки или рекомендовать его друзьям?

- Могли бы вы встретить подобную статью в печатном журнале, книге или энциклопедии?

- Не отвлекает ли внимание читателей реклама на сайте?

- Уделяете ли вы внимание деталям при создании страниц?

Какие именно факторы учитывает Панда при ранжировании сайтов, наверняка не знает никто. Поэтому лучше всего сфокусироваться на создании максимально интересного и полезного сайта. В особенности вам нужно уделить внимание таким моментам:

- « Недостаточный» контент. В данном контексте термин «недостаточный» подразумевает, что контент на вашем сайте не представляет новизны или ценности для читателя, так как не раскрывает тему должным образом. И дело вовсе не в количестве символов, так как иногда даже пара предложений может нести немалую смысловую нагрузку. Конечно, если большинство страниц вашего сайта будут содержать обрывки текста из нескольких предложений, Google сочтет его некачественным.

- Дублированный контент. Панда посчитает ваш сайт некачественным в том случае, если большая часть его контента скопирована из других источников или если на сайте есть страницы с дублированным или схожим контентом. Это распространенная проблема Интернет-магазинов, которые продают сотни товаров, различных лишь по одному параметру (например, по цвету). Чтобы избежать этой проблемы, используйте тег canonical.

- Некачественный контент. Google любит сайты, которые постоянно обновляются, поэтому многие оптимизаторы рекомендуют ежедневно публиковать новые материалы. Однако если вы будете публиковать некачественный контент, не представляющий ценности для пользователей, то такая тактика принесет больше вреда.

Как выйти из-под фильтра Панда?

Google ежемесячно обновляет алгоритм Панда. После каждого обновления поисковые роботы пересматривают все сайты и проверяют их на соответствие установленным критериям. Если вы попали под фильтр Панда, после чего внесли изменения на сайте (изменили недостаточный, некачественный и неуникальный контент), позиции вашего сайта улучшатся после очередного обновления. Учтите, что, скорее всего, вам придется ждать восстановления позиций несколько месяцев.

Google пингвин – Охотник за ссылками

Алгоритм Google Пингвин был запущен 24 апреля 2012 года. В отличие от Панды, этот алгоритм нацелен на борьбу с неестественными обратными ссылками .

Авторитет и значимость сайта в глазах поисковых систем во многом зависит от того, какие сайты на него ссылаются. При этом одна ссылка с авторитетного источника может иметь такой же вес, как десятки ссылок с малоизвестных сайтов. Поэтому раньше оптимизаторы стремились всеми возможными путями получить максимальное количество внешних ссылок.

Google научился распознавать разные манипуляции с ссылками. Как именно работает Пингвин, известно только его разработчикам. Все, что известно оптимизаторам, так это то, что этот алгоритм охотится за некачественными ссылками, созданными веб-мастерами вручную с целью повлиять на позиции сайта. Сюда относятся:

- покупные ссылки;

- обмен ссылками;

- ссылки с нерелевантных сайтов;

- ссылки с сайтов-сателлитов;

- участие в ссылочных схемах;

- другие манипуляции.

Как выйти из-под фильтра Пингвин?

Пингвин – такой же фильтр, как и Панда. Это означает, что он регулярно обновляется и пересматривает сайты. Чтобы выйти из-под фильтра Пингвин, вам нужно избавиться от всех неестественных ссылок и ждать обновления.

Если вы добросовестно последуете рекомендациям Google и не будете пытаться получить ссылки нечестным путем, то сможете вернуть себе расположение поисковых систем. Однако чтобы вернуть первые позиции, вам не достаточно будет просто удалить некачественные ссылки. Вместо них вам нужно заработать естественные редакторские ссылки с трастовых сайтов.

Google Колибри – самый «понимающий» алгоритм

Алгоритм Колибри – это совсем другой «зверь». Google объявил о запуске этого обновления 26 сентября 2013 года, но он также упомянул о том, что этот алгоритм действует уже на протяжении месяца. Вот почему владельцы сайтов, позиции которых упали в начале октября 2013 года, ошибочно полагают, что они попали под фильтр Колибри. Если бы это действительно было так, они ощутили бы действие этого алгоритма на месяц раньше. Вы спросите, а что же в таком случае послужило причиной снижения трафика? Скорее всего, это было очередное обновление Пингвина, которое вступило в силу 4 октября того же года.

Алгоритм Колибри был разработан для того, чтобы лучше понимать запросы пользователей. Теперь, когда пользователь вводит запрос «В каких местах можно вкусно поесть в Екатеринбурге», поисковая система понимает, что под словом «места» пользователь подразумевает рестораны и кафе.

Как поднять себя в глазах Google Колибри?

Поскольку Google стремится как можно лучше понимать пользователей, вы должны делать то же самое. Создавайте контент, который будет давать максимально развернутые и полезные ответы на запросы пользователей, вместо того, чтобы зацикливаться на продвижении по ключевым словам.

В заключение

Как видите, все поисковые алгоритмы преследуют одну цель – заставить веб-мастеров создавать качественный, интересный и полезный контент. Помните: Google постоянно работает над повышением качества результатов поиска. Создавайте контент, который поможет пользователям найти решение их проблем, и первые места в выдаче вам гарантированы.

В августе 2011 года введённый в действие для всех сегментов Всемирной паутины. Для англоязычных интернет-пользователей алгоритм был запущен немного ранее – в апреле того же года. Разработчиками нового алгоритма стали сотрудники поискового гиганта Амит Сингал и Мэтт Катс. Новый алгоритм радикально отличается от прежних разработок своей ориентированностью на человеческий фактор. Однако алгоритм учитывает при ранжировании и обычные критерии.

Уникальность контента

Неповторимость текстового наполнения учитывается Пандой в виде процентного соотношения копипаста как для конкретной страницы, так и для сайта в целом. Другими словами, теперь наличие заимствований ухудшает не только позиции конкретной страницы, но и всего «пиратского» ресурса. Плюс к тому, Панда легко отслеживает такой показатель, как шаблонность. Проще говоря, алгоритм устанавливает похожие по содержанию страницы, контент которых создаётся даже под разные ключевые запросы .

Релевантность рекламы

Реклама детского питания, размещённая на странице интернет-магазина, который продаёт тяжёлые грузовики, почти гарантированно вызовет «неудовольствие» поисковика . Такое внимание Google к качеству размещения рекламы призвано остудить пыл к зарабатыванию денег неразборчивыми оптимизаторами и веб-мастерами . Цель – поднятие сайтов, по-настоящему соответствующих заявленной тематике

Ссылочная масса

Здесь речь идёт как о размещённых, так и об обратных ссылках . Требование одно – нахождение сайтов в едином информационном пространстве. То есть, сайты, обменивающиеся ссылочной массой, должны быть максимально схожи по тематике. Количество обратных ссылок , конечно, учитывается Пандой, но является далеко не определяющим при ранжировании.

Человеческий фактор

В данном случае было бы правильнее оперировать SEO-терминологией, в которой человеческий фактор называется поведенческим . Поисковый алгоритм Панда как никакой другой до него придирчиво учитывает поведение пользователя на сайте. Очевидно, что для этого разработчикам необходимо было колоссальное усложнение алгоритма, поэтому, к слову сказать, алгоритм так долго запускался для всего интернета – создатели до бесконечности шлифовали поисковые инструменты.

Однако результаты, прямо скажем, впечатляют. На топовые позиции в Google на сегодня способны выйти по-настоящему полезные сайты. Благодаря использованию нового алгоритма поисковая система Google реально стала мощнейшим поисковиком на планете, что подтверждается не только ростом количества пользователей этого сервиса, но и уровнем капитализации Google, который перевалил за 200 миллиардов долларов. Пользователя ещё можно обмануть различными модными фишками и агрессивной рекламой, но инвестора дешёвыми трюками не взять. Он чувствует, что Google – дело прибыльное. И это не в последнюю очередь благодаря Панде.

Итак, поведенческие факторы. К ним относится, в принципе ограниченный набор критериев:

- показатель отказов;

- время, проведенное пользователем на сайте;

- соотношение возвратов на сайт к общему количеству переходов.

Причём, Панда обращает внимание, так сказать, на деталировку каждого показателя. Проще говоря, учитывается, например, не только время, в течение которого пользователь оставался на сайте, но и то, какие действия он там производил, к примеру, совершал ли переходы по ссылкам, так или иначе относящимся к предмету, который содержался в ключевом запросе. Словом, алгоритм даёт возможность определить не только факт привлекательности и полезности данного ресурса для пользователя, но и степень этой привлекательности, средства, которые делают данный сайт таковым.

Оптимизатор, продвигающий сайты в Google, может сегодня даже при сравнительно небольшой ссылочной массе получить достаточно высокие позиции в выдаче . Для этого необходима грамотная перелинковка внутренних страниц сайта и в целом повышение удобства ресурса для каждого пользователя – и для гуру, и для того, кто лишь вчера услышал слово «интернет». На этом стоит новый поисковый алгоритм Google – Panda.